Misinformation und Fake News in den Sozialen Medien

Einblicke in die interdisziplinäre Forschungslage

Jula Lühring

Universität Wien & Complexity Science Hub

VHS Schwerpunkt Demokratie am 7. Oktober 2024

Vorstellung

Jula Lühring, M.Sc., B.A.

- Studium in Bremen und Amsterdam

- Arbeit im Bereich der Demokratieförderung

- Doktorandin im Computational Communication Science Lab & Complexity Science Hub

Computational Communication Science?

Theorie:

Kommunikationswissenschaft, Psychologie, Soziologie

Methodik:

Informatik, Physik

\(\rightarrow\) interdisziplinär!

Misinformation

\(\rightarrow\) Psychologie

\(\rightarrow\) Informatik

\(\rightarrow\) Kommunikations- und Medienwissenschaften

\(\rightarrow\) Soziologie

\(\rightarrow\) Politikwissenschaften

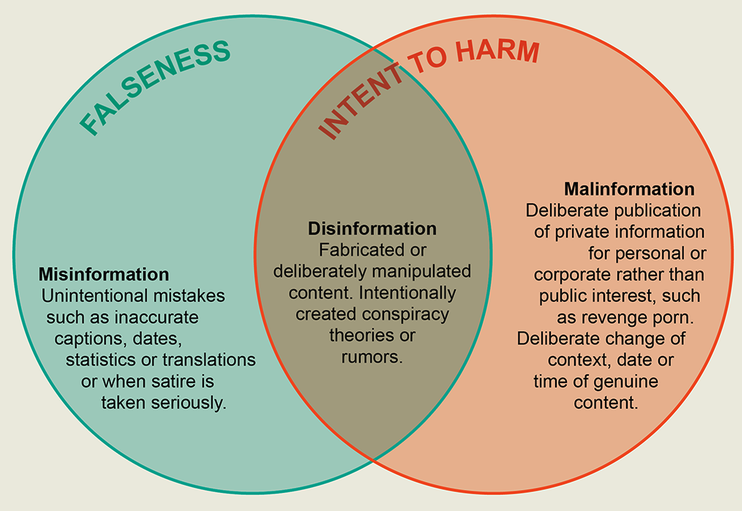

Was ist Misinformation?

Im Kontext der “Information Disorder”

Trennung von Mis- und Desinformation

Fake News als Subtyp von Desinformation

Fokus auf Schädlichkeit

Misinformation = unwahre Informationen ohne bestimmte Intention

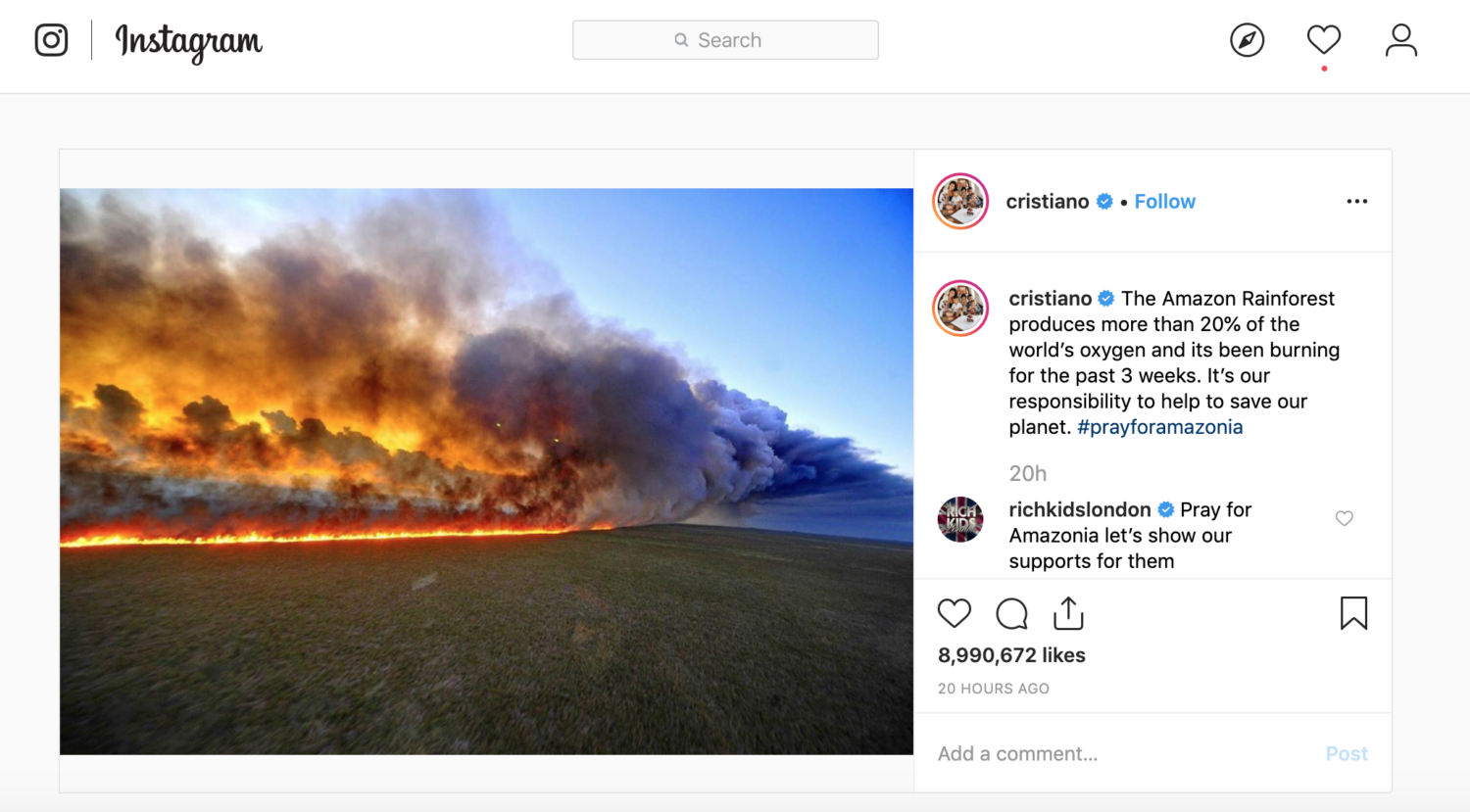

Wie sieht das in der Praxis aus?

Beispiel 1: Unüberprüftes Teilen von Informationen

\(\rightarrow\) unabsichtliche Fehler

Poynter, 2019

Wie sieht das in der Praxis aus?

Beispiel 2: Falsche Zeugenaussagen

\(\rightarrow\) dekontextualisierende Interpretationen

Deutschlandfunk, 2017

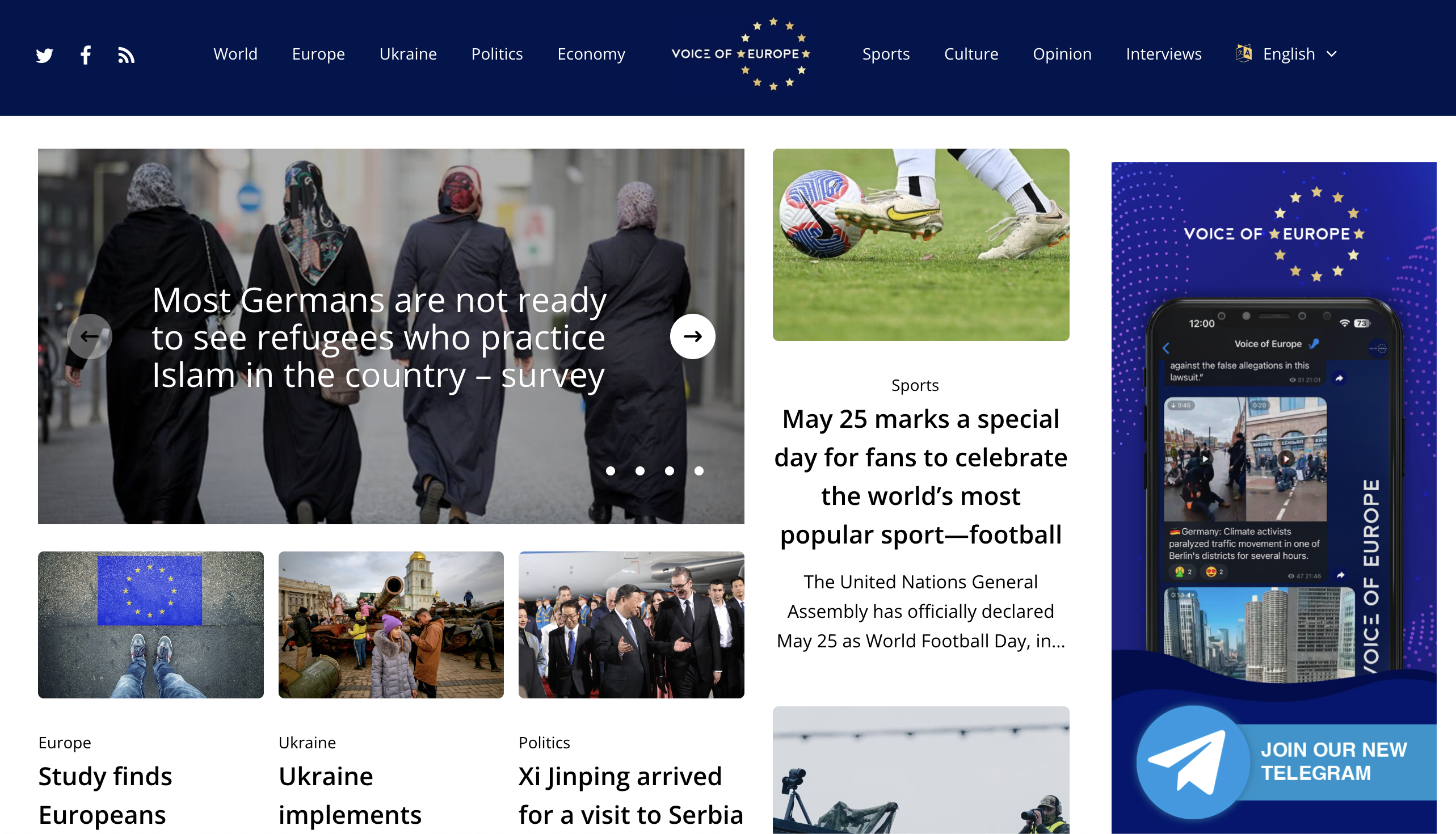

Wie sieht das in der Praxis aus?

Beispiel 3: Pseudojournalismus

\(\rightarrow\) politisch motivierte Desinformationskampagnen

Europäische Kommission, 2024

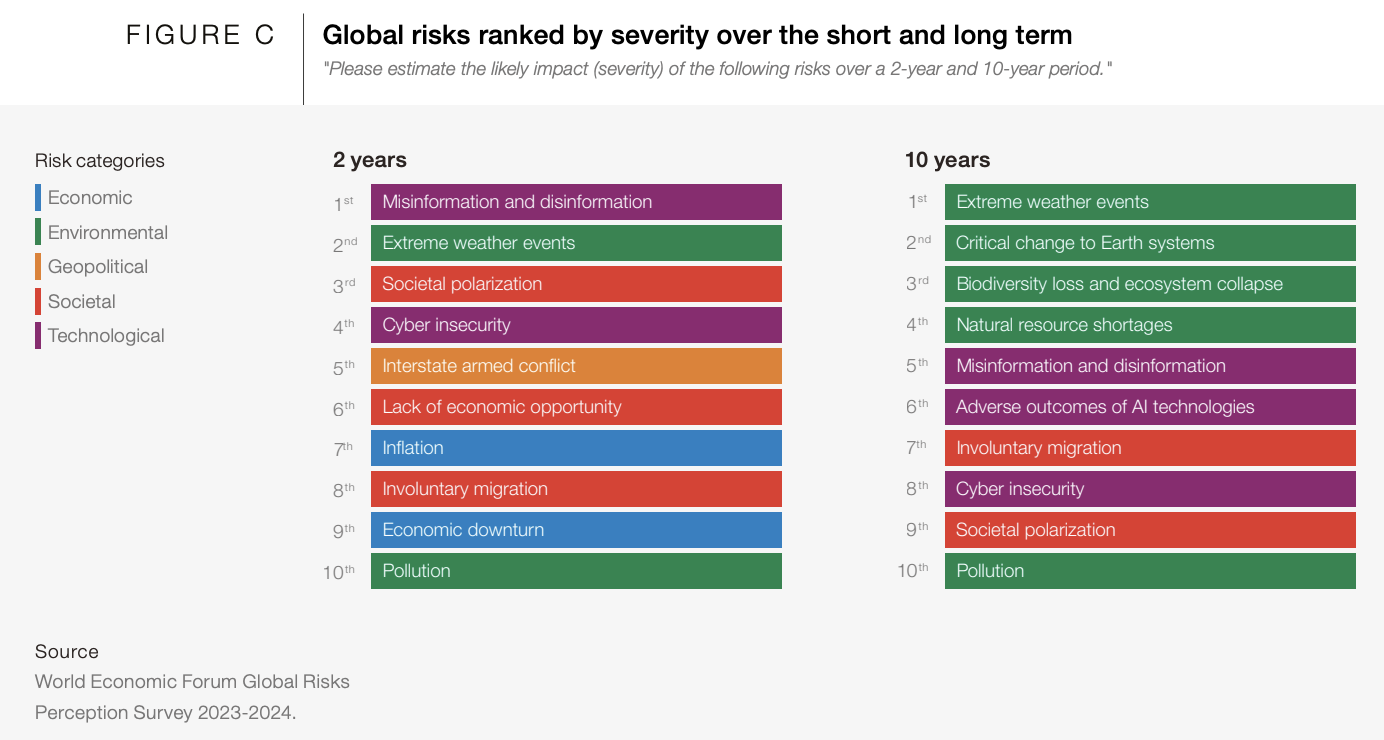

Wie verbreitet ist Misinformation?

Was denken Sie?

So denken andere darüber

Realitätscheck

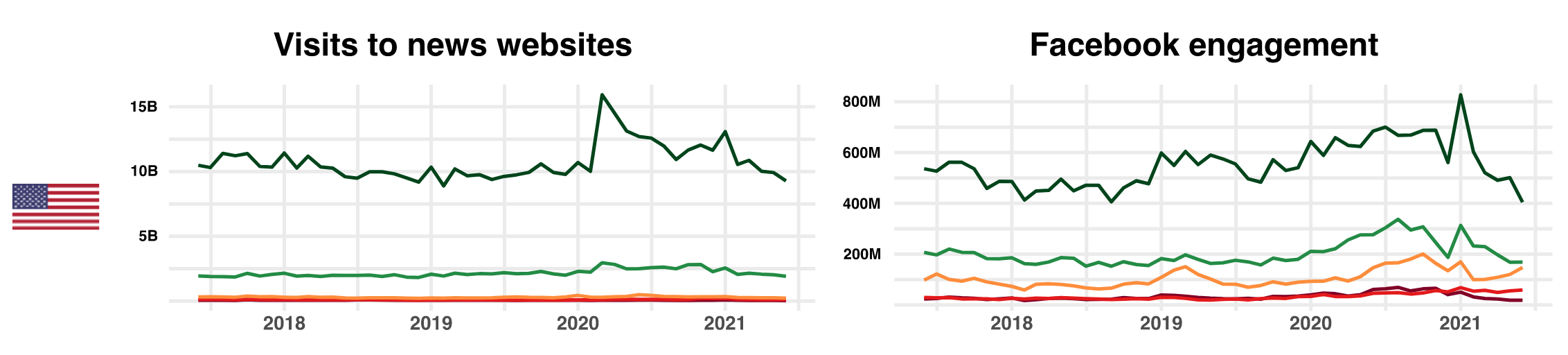

Wie verbreitet ist Misinformation?

Altay et al., 2022

0.3-6% in 5 Studien von 2016-2021

kleiner Anteil des Online-Nachrichtenkonsums (in den USA!)

in Krisen sogar Rückgriff auf zuverlässige Nachrichten

\(\rightarrow\) im Durschnitt gewinnen gute Nachrichten!

Und in den sozialen Medien?

- Minderheit der Nutzer teilt Großteil der Misinformation

- 1% Nutzer teilen 75% (2018-2019, USA)

- 5% Nutzer teilen 50% (2016, USA)

- 2% Nutzer besuchen 75% Websites (2022, Deutschland)

- Aber: Misinformation ist stark verbreitet in Kontexten von Konflikt und Hassrede

Wer verbreitet Misinformation?

1. Politiker

- Politiker teilen 20% der Misinformation

- Verurachen wiederum 69% der Interaktionen mit Misinformation in Sozialen Medien

Wer verbreitet Misinformation?

2. Sehr aktive, extreme Nutzer

- politisch Motivierte mit extremen Einstellungen

- auch offline feindselig, online sichtbarer

Warum?

- Verlust von Status & Privileg

- Frustration im echten Leben

- kein Vertrauen in Institutionen

- kaum Repräsentation

Mensch oder Algorithmus?

Digitale Echokammern (“Filterblasen”)

- Echokammern: offline stärker als online

- Ausmaß variiert stark, z.B. auf Facebook:

- 20.6% Nutzer: 75% der Inhalte aus gleichgesinnten Quellen

- 23.1% Nutzer: unter 25% der Inhalte

- Algorithmen: kleiner (6%) & weniger starker Einfluss als soziales Netzwerk

- Gruppen & Pages: stark segregiert

Verbreiten Algorithmen Misinformation?

Down-Ranking von gleichgesinnten Inhalten auf Facebook:

weniger Misinformation & Hassrede

Nutzer finden trotzdem gleichgesinnte Inhalte

Nyhan et al., 2023

Algorithmus nein, Mensch ja

mehr Misinformation ohne Algorithmus

weniger Misinformation ohne Reshares

Algorithmen & Radikalisierungspiralen?

Google: Suchworte haben stärkeren Effekt als Vorschläge durch Algorithmus

YouTube: Algorithmus führt zu weniger radikalem Konsum

- Angebot/Nachfrage existiert außerhalb der Platform

- Nutzer-Präferenzen bestimmen Klicks von radikalen Videos

\(\rightarrow\) Nutzer suchen aktiv gleichgesinnte Inhalte

Echokammern reduzieren?

höhere Sichtbarkeit von Inhalten der anderen Partei

Einstellungen wurden extremer, besonders bei Republikanern

\(\rightarrow\) Extreme, konträre Stimmen verstärken Polarisierung

Bail et al., 2018

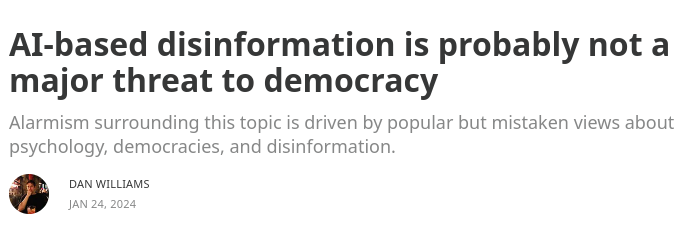

Und was ist mit KI?

Nur weil es mehr gibt, wird nicht mehr konsumiert

Nur weil es hochwertig produziert ist, ist es nicht wahr

Nur weil es personalisiert ist, überzeugt es nicht

\(\rightarrow\) KI hat gleichzeitig auch Potenzial für Qualitätsmedien!

Zuletzt: Russland?!

Russische Desinformation erreicht nur kleine Teile der Gesellschaft

Interaktionen sind gering, insbesondere im Vergleich zu anderen Inhalten

- Es gibt keine Beweise dafür, dass russische Desinformation Einstellungen oder Wahlen beeinflusst wurden

Zusammenfassung

Misinformation ist weniger verbreitet als im öffentlichen Diskurs angenommen

Der Ursprung von Misinformation liegt nicht in sozialen Medien, inklusive Algorithmen und KI

Die Gefahren von russischer Desinformation werden überschätzt

\(\rightarrow\) Menschliche Tendenzen werden ausgespielt und verstärkt

\(\rightarrow\) Misinformation überlappt mit anderen gesellschaftlichen Problemen

Fragen?

Unterbrechung

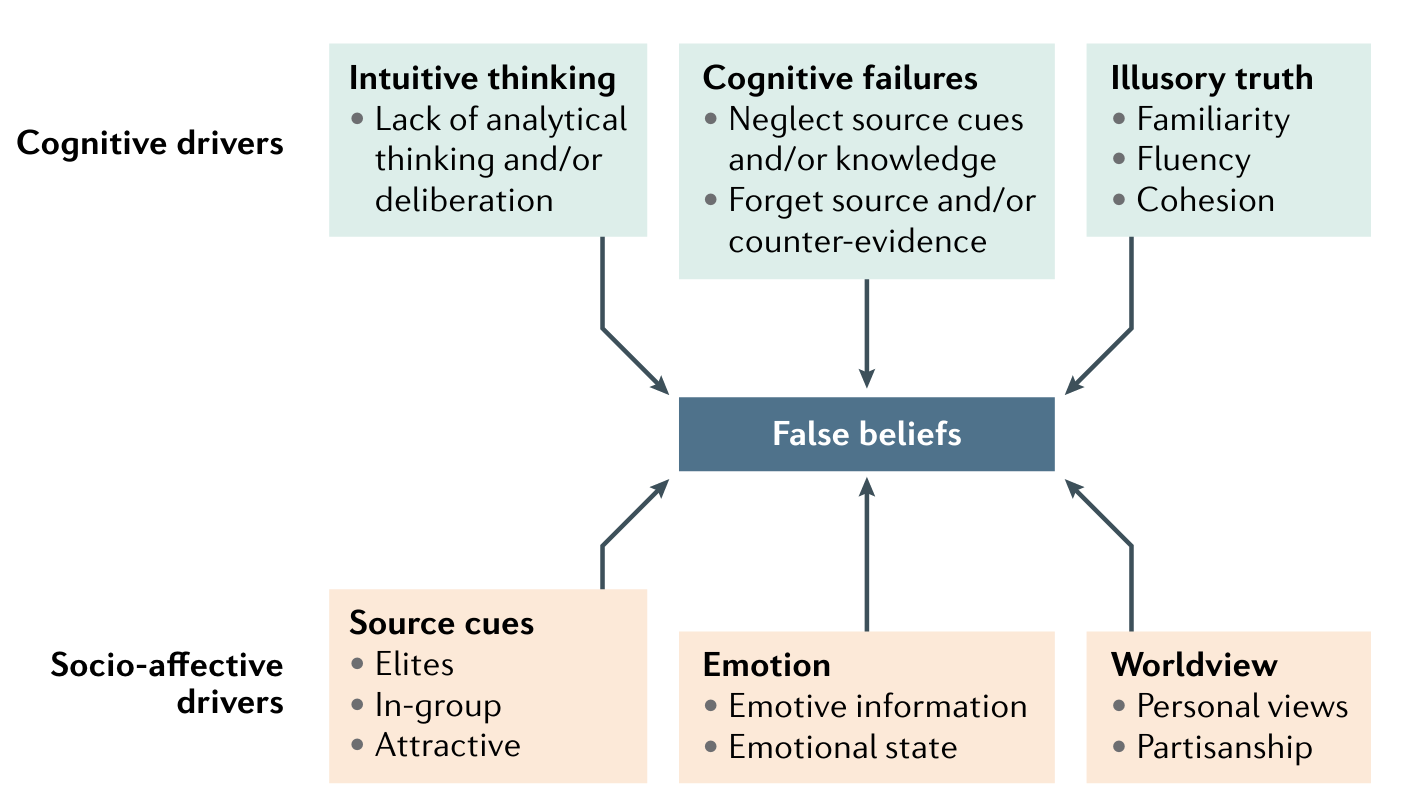

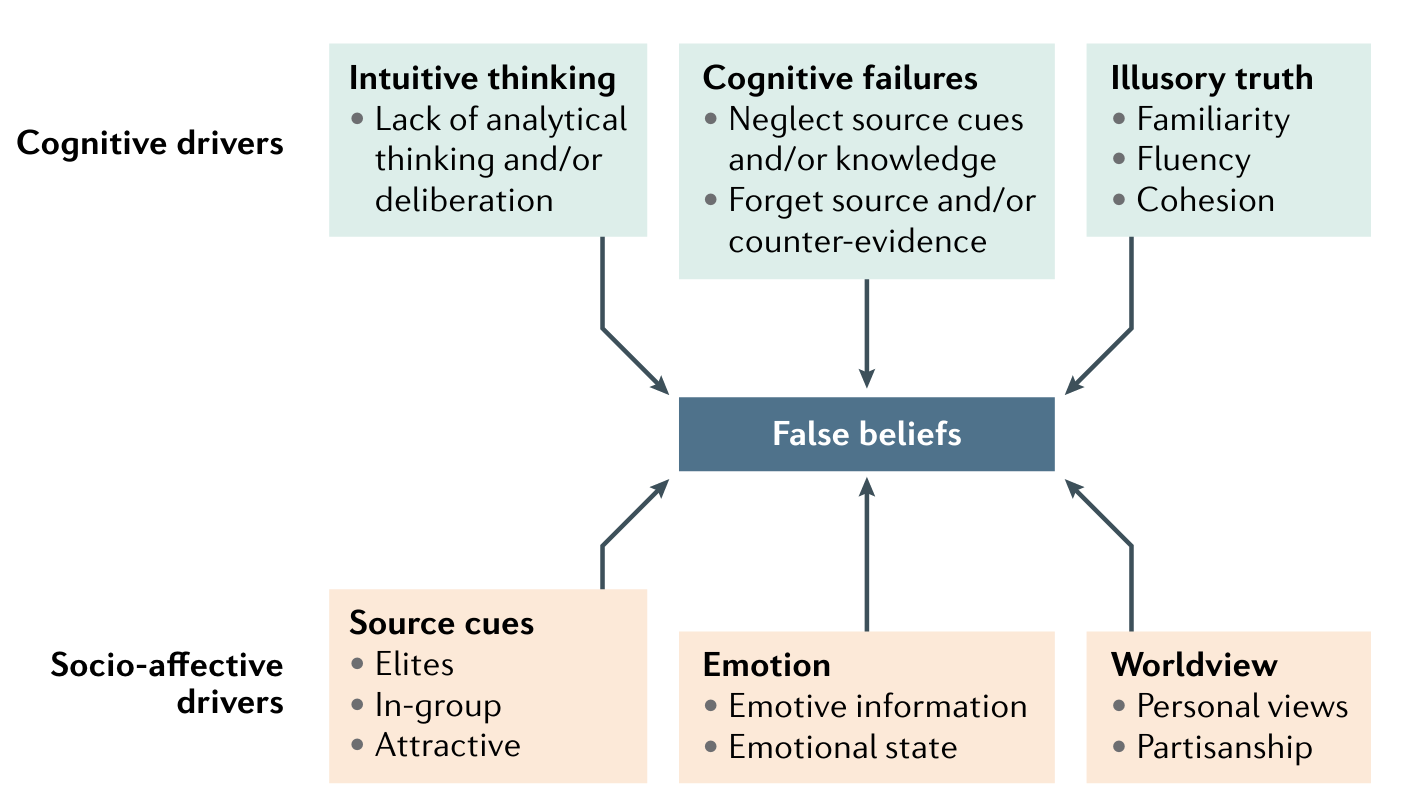

Der Faktor Mensch

Warum glauben Menschen an Misinformation?

Manche Menschen fallen einfach drauf rein

Menschen sind grundsätzlich eher skeptisch

Mercier, 2020

Machen Emotionen dumm? Nein!

- im Kontext Misinformation: mehr Wut und weniger Freude

- Menschen mit guter & schlechter Urteilsfähigkeit werden wütend

\(\rightarrow\) Funktion von Emotionen hängt von Einstellungen ab

Luehring*, Shetty*, et al., 2023

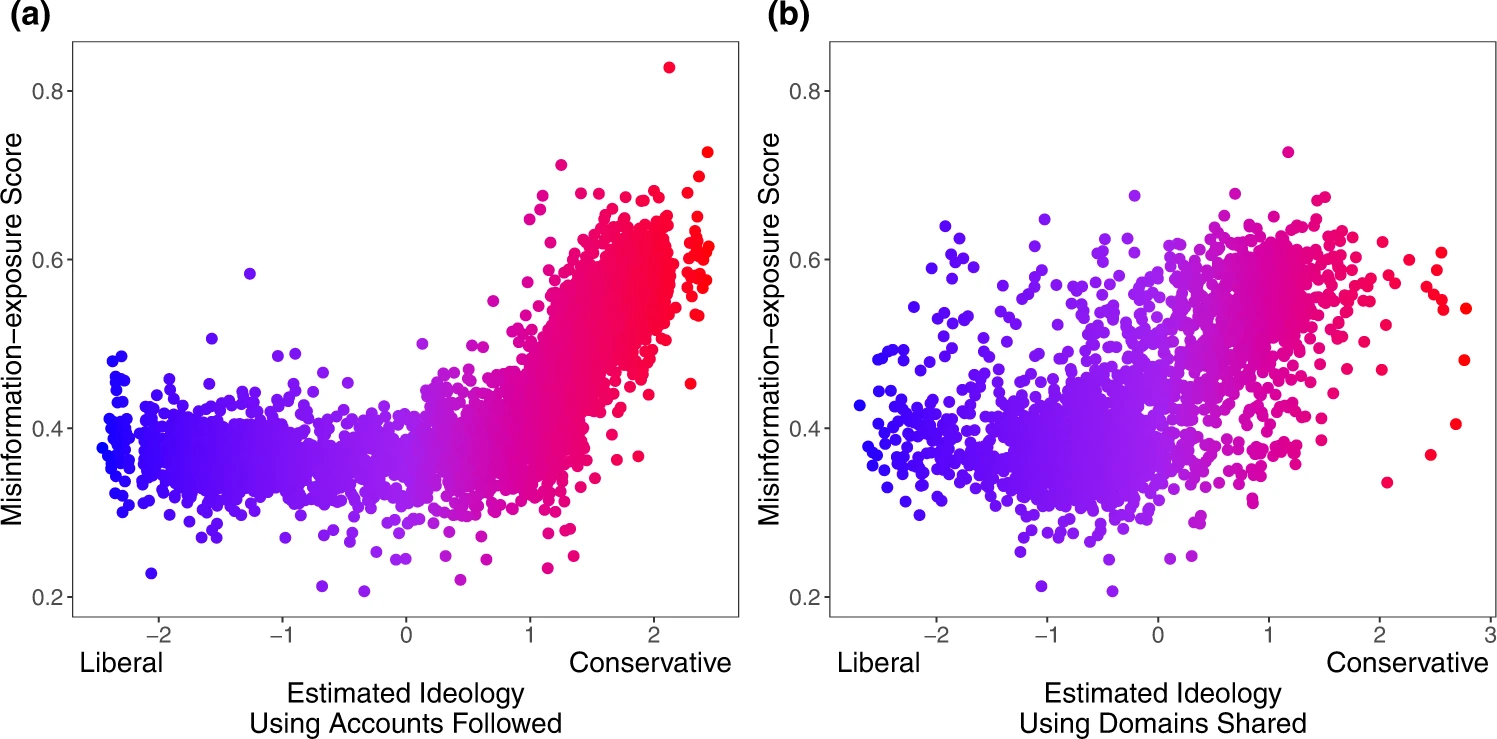

Politische Einstellungen

\(\rightarrow\) politische Asymmetry

Soziale Dynamiken in den sozialen Medien

- Soziale Identitäten

- Gruppenzugehörigkeit und -abgrenzung

- Mobilisierung und Vernetzung

Suche nach sozialem Status

- Wettbewerb von Gruppen

- Status für politisch Motivierte

- Anonymität

Soziale Medien verzerren die Wirklichkeit

- laute Minderheiten

- Moderate melden sich nicht zu Wort

- Bsp: Klimawandel + Wirtschaft

Scheinbare Polarisierung

\(\rightarrow\) Wahrgenommene politische Spaltung verstärkt die emotionale Polarisierung

Persönliche Konsequenzen von Misinformation

kognitiv (Effekte auf Wissen)

emotional (Effekte auf Gefühle)

einstellungsbezogen (Effekte auf Meinungen)??

Verhalten???

\(\rightarrow\) sehr limitierte Effekte!

Gesellschaftliche Konsequenzen von Misinformation

gruppenbezogene Wahrnehmungsverzerrungen

Mobilisierung und Spaltung durch die oft extremen Inhalte

Zynismus

Verringertes Vertrauen in die Medien und demokratische Institutionen

Was können wir tun?

Interventionen: Prebunking

\(\rightarrow\) Menschen sind nicht dumm! Argumente wirken, aber nur dort, wo die oft guten Gründe liegen

Interventionen: Debunking

Factchecking

Expert:innen: unabhängige Organisationen (mimikama, Correctiv) oder als Teil von Redaktionen (APA, faktenfinder)

Crowdsourced: Birdwatch

Interventionen: Systemisch

Transparenzpflichten und Regulierung von sozialen Medien und Suchmaschinen (z.B. EU Digital Services Act)

Soziale Medien für bestimmte Zwecke designen (Entertainment, politischer Diskurs, Vernetzung, …)

- Anonymität aufheben, Übereinstimmung betonen, usw.

Stärkung von unabhängigen Medien und zuverlässigen Informationen

Politische Bildung und Extremismus-Prävention

\(\rightarrow\) Vertrauen gewinnen!

Was können Sie tun?

- Zuhören und Nachfragen: Ausgrenzung hat gegenteilige Effekte!

- Über persönliche Erfahrungen & Nicht-Politisches sprechen

- Werte/Weltsicht berücksichtigen

- Argumente wirken!

- Ursachen des Klimawandels erklären erhöht Akzeptanz von Maßnahmen

Abschluss

Letzte Worte

Soziale Medien treiben scheinbare Polarisierung an

Soziale Faktoren wirken stärker als KI

Menschen sind nicht dumm: Sorgen ernst nehmen, Gründe verstehen, und diskutieren

Reale Probleme lösen & transparente Erklärungen anbieten

Für Neugierige

Bücher

Mercier, 2020 Misinformation & Propaganda

Bail, 2021 Polarisierung & Soziale Medien

Vielen Dank!

Die Präsentationsfolien zum Nachschauen:

julaluehring.github.io